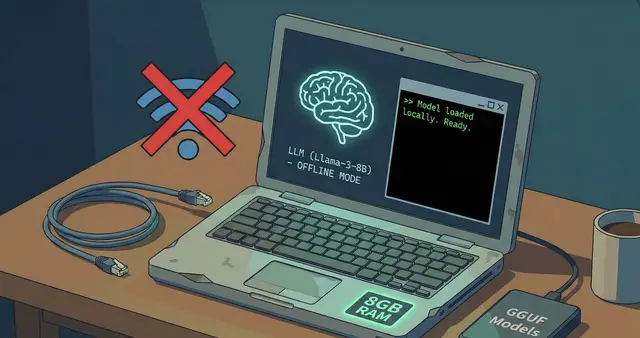

Cara Menjalankan LLM di Laptop Kentang (RAM 8GB) Tanpa Internet

Cara Menjalankan LLM di Laptop Kentang (RAM 8GB) Tanpa Internet

Pernah kepikiran untuk menjalankan AI chatbot seperti ChatGPT di laptop sendiri? Tapi spesifikasi laptop pas-pasan dan koneksi internet sering lemot? Tenang, sekarang kamu bisa menjalankan Large Language Model (LLM) di laptop dengan RAM 8GB tanpa perlu koneksi internet!

Kenapa Harus Menjalankan LLM Secara Lokal?

Sebelum masuk ke tutorial, mari kita bahas dulu kenapa kamu perlu menjalankan LLM di laptop sendiri:

1. Privasi Terjamin

Data dan percakapan kamu tidak akan dikirim ke server pihak ketiga. Semua proses terjadi di laptop kamu sendiri.

2. Gratis dan Tanpa Batas

Tidak perlu berlangganan ChatGPT Plus atau layanan berbayar lainnya. Sekali setup, bisa digunakan selamanya tanpa biaya tambahan.

3. Bekerja Offline

Tidak perlu koneksi internet. Cocok untuk kamu yang sering bekerja di tempat dengan koneksi internet terbatas.

4. Kontrol Penuh

Kamu bisa memilih model yang sesuai dengan kebutuhan dan spesifikasi laptop kamu.

Persiapan yang Dibutuhkan

Sebelum memulai, pastikan laptop kamu memenuhi spesifikasi minimal berikut:

- RAM: Minimal 8GB (recommended 16GB)

- Storage: Minimal 10GB ruang kosong

- Processor: Intel Core i5 generasi ke-8 atau AMD Ryzen 5 (atau yang lebih baik)

- OS: Windows 10/11, macOS, atau Linux

Tools yang Akan Digunakan

Kita akan menggunakan beberapa tools open-source yang powerful:

- LM Studio - Platform untuk menjalankan LLM secara lokal

- Model LLM yang ringan - Seperti Llama 2 7B, Mistral 7B, atau Phi-2

Langkah 1: Install LM Studio

Untuk Windows

- Download installer LM Studio dari lmstudio.ai

- Jalankan file installer yang sudah didownload

- Ikuti instruksi instalasi hingga selesai

- Buka Command Prompt atau PowerShell untuk verifikasi:

lmstudio --version

Untuk macOS

- Download installer untuk macOS dari website LM Studio

- Drag aplikasi LM Studio ke folder Applications

- Buka Terminal dan verifikasi instalasi:

lmstudio --version

Untuk Linux

Jalankan command berikut di terminal:

curl -fsSL https://lmstudio.ai/install.sh | sh

Langkah 2: Download Model LLM

Setelah LM Studio terinstall, saatnya download model LLM. Untuk laptop dengan RAM 8GB, berikut rekomendasi model yang cocok:

Model Rekomendasi untuk RAM 8GB

1. Phi-2 (2.7B parameters) - Paling Ringan

lmstudio pull phi

- Ukuran: ~1.6GB

- RAM Usage: ~3-4GB

- Kecepatan: Sangat cepat

- Cocok untuk: Coding, Q&A sederhana, brainstorming

2. Llama 2 7B - Balanced

ollama pull llama2

- Ukuran: ~3.8GB

- RAM Usage: ~5-6GB

- Kecepatan: Sedang

- Cocok untuk: General purpose, conversation, writing

3. Mistral 7B - Paling Powerful

ollama pull mistral

- Ukuran: ~4.1GB

- RAM Usage: ~6-7GB

- Kecepatan: Agak lambat di RAM 8GB

- Cocok untuk: Complex reasoning, detailed writing

Tips: Untuk laptop dengan RAM 8GB, saya sangat merekomendasikan Phi-2 atau Llama 2 untuk performa optimal.

Tes gambar

Optional Caption

Optional Caption

Langkah 3: Menjalankan Model

Setelah model selesai didownload, kamu bisa langsung menjalankannya:

ollama run phi

atau

ollama run llama2

Tunggu beberapa saat hingga model loading, kemudian kamu bisa langsung chat!

Contoh Percakapan

>>> Halo! Bisa jelaskan apa itu machine learning?

Machine learning adalah cabang dari artificial intelligence yang

memungkinkan komputer untuk belajar dari data tanpa diprogram secara

eksplisit. Sistem akan menganalisis pola dari data yang diberikan

dan membuat prediksi atau keputusan berdasarkan pola tersebut...

Langkah 4: Menggunakan Interface yang Lebih Friendly

Jika kamu tidak nyaman dengan command line, kamu bisa menggunakan interface web:

Install Open WebUI

- Pastikan Docker sudah terinstall di laptop kamu

- Jalankan command berikut:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway \

-v open-webui:/app/backend/data --name open-webui \

--restart always ghcr.io/open-webui/open-webui:main

- Buka browser dan akses

http://localhost:3000 - Kamu akan mendapatkan interface seperti ChatGPT!

Tips Optimasi untuk Laptop Kentang

1. Tutup Aplikasi Lain

Saat menjalankan LLM, tutup aplikasi lain yang memakan RAM seperti browser dengan banyak tab, Photoshop, atau game.

2. Gunakan Model Quantized

Model quantized adalah versi yang sudah dikompres untuk mengurangi penggunaan RAM:

ollama pull llama2:7b-chat-q4_0

3. Atur Context Length

Kurangi context length untuk menghemat RAM:

ollama run llama2 --ctx-size 2048

4. Monitor Penggunaan Resource

Gunakan Task Manager (Windows) atau Activity Monitor (macOS) untuk memantau penggunaan RAM dan CPU.

Troubleshooting

Model Terlalu Lambat

- Coba gunakan model yang lebih kecil (Phi-2)

- Kurangi context length

- Pastikan tidak ada aplikasi lain yang berjalan

Out of Memory Error

- Gunakan model quantized (Q4 atau Q5)

- Restart laptop untuk membersihkan RAM

- Upgrade RAM jika memungkinkan

Model Tidak Merespon dengan Baik

- Coba model yang berbeda

- Perhatikan cara prompt yang kamu gunakan

- Beberapa model lebih baik untuk task tertentu

Alternatif Tools Lainnya

Selain Ollama, ada beberapa alternatif yang bisa kamu coba:

1. LM Studio

- Interface GUI yang user-friendly

- Support banyak model

- Download: lmstudio.ai

2. GPT4All

- Sangat ringan dan mudah digunakan

- Cross-platform

- Download: gpt4all.io

3. Jan

- Open-source dan privacy-focused

- Interface modern

- Download: jan.ai

Use Cases Praktis

Berikut beberapa cara praktis menggunakan LLM lokal:

1. Coding Assistant

>>> Buatkan fungsi Python untuk menghitung faktorial

def factorial(n):

if n == 0 or n == 1:

return 1

return n * factorial(n - 1)

2. Writing Assistant

>>> Buatkan outline untuk artikel tentang AI

1. Pendahuluan: Apa itu AI?

2. Sejarah perkembangan AI

3. Jenis-jenis AI

4. Aplikasi AI dalam kehidupan sehari-hari

5. Tantangan dan masa depan AI

6. Kesimpulan

3. Learning Companion

>>> Jelaskan konsep OOP dengan analogi sederhana

OOP seperti membangun rumah dengan blueprint. Class adalah

blueprint rumah, sedangkan object adalah rumah yang sudah

jadi. Setiap rumah (object) punya karakteristik yang sama

(properties) tapi bisa berbeda warna atau ukuran...

Kesimpulan

Menjalankan LLM di laptop dengan RAM 8GB tanpa internet ternyata sangat memungkinkan! Dengan tools seperti lmstudio dan Ollama serta model yang tepat, kamu bisa:

✅ Menghemat biaya langganan AI

✅ Menjaga privasi data

✅ Bekerja offline kapan saja

✅ Belajar dan bereksperimen dengan AI

Selamat mencoba! Jika ada pertanyaan atau kendala, jangan ragu untuk bertanya di kolom komentar. Happy experimenting! 🚀

Tags: #AI #LLM #Tutorial #Offline #LocalAI #Ollama #MachineLearning #TechTips